-

خانهخانه

-

مقالاتمقالات

-

فروشگاهفروشگاه

-

طراحی سایتطراحی سایت

-

درباره مادرباره ما

-

حمایت از ماحمایت از ما

-

ارتباط با ماارتباط با ما

اگر این مقاله را دوست دارید، لطفا آن را با دوستان خود به اشتراک بگذارید.

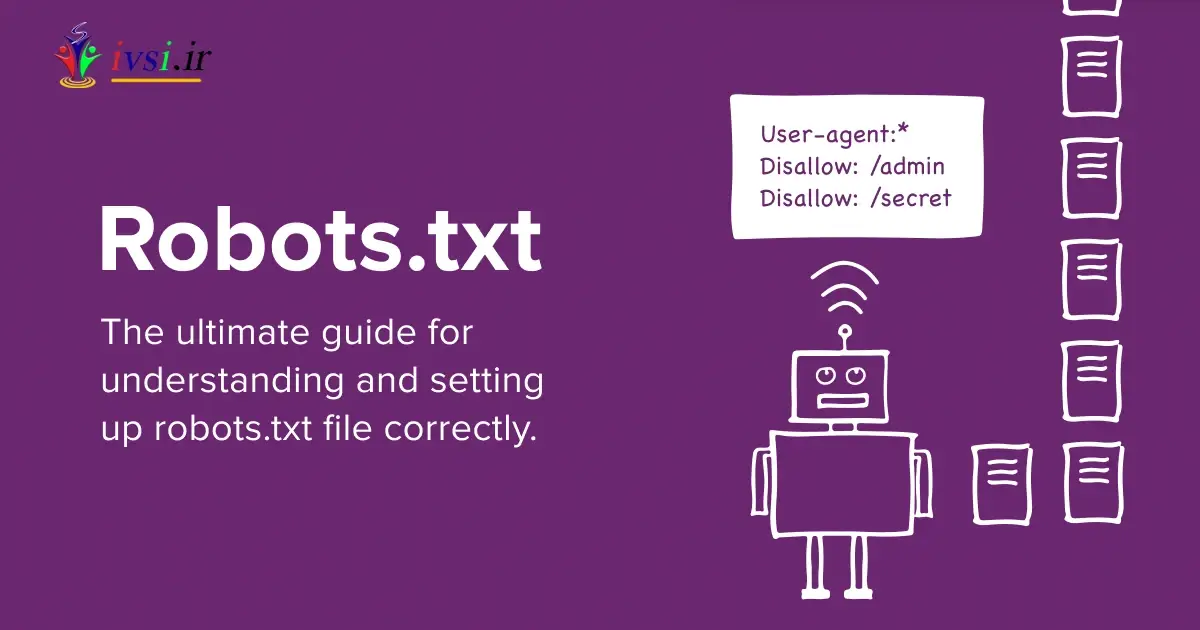

ارائهدهندگان موتورهای جستجو و سایر کاربران آنلاین اغلب از رباتها یا رباتها برای انجام کارهای خودکار مانند نمایهسازی استفاده میکنند که میتواند به ظاهر شدن سایتها در هنگام جستجوی کلمات کلیدی خاص کمک کند. صاحبان وبسایتها اغلب یک فایل robots.txt ایجاد میکنند که میتواند به آنها کمک کند به طور خودکار به این رباتها پاسخ دهند و به اطلاعات خاصی هدایت شوند. آشنایی با این سند و نحوه استفاده از آن می تواند به ایمن و قابل کشف سایت شما کمک کند.

در این مقاله از ایوسی، ما درباره چیستی سند robots.txt و کاربردهای آن بحث میکنیم و اطلاعات مفیدی مانند نحوه استفاده از این فایلها را با نکاتی آشکار میکنیم.

فایل robots.txt یا استاندارد حذف روبات ها، فایلی است که به کاربران کمک می کند تا وب سایت ها یا عناصر موجود در یک صفحه را پیدا کرده و فهرست بندی کنند. همانطور که موتورهای جستجو و گاهی اوقات بدافزارها خزیدن یا نمایه سازی صفحات جداگانه را انجام می دهند، به مدیریت درخواست ها کمک می کنند. هر بار که یک موتور جستجو داده ها را از سایت شما جمع آوری می کند، اطلاعات خاصی را درخواست می کند. این فایل به خزنده هدایت می کند تا اطلاعات خاصی را که ممکن است به آن نیاز داشته باشد شناسایی و جمع آوری کند. هر کدام یک URL خاص دارند که در یک وب سایت میزبانی شده است. این معمولاً هدایتهایی به این پیوند ندارد، بنابراین کاربران معمولی اغلب متوجه آن نمیشوند. برخی از نحو استفاده شده در این فایل برای هدایت روبات ها عبارتند از:

عامل کاربر : عامل های کاربر موتورهای جستجو یا سایر نرم افزارهایی هستند که ربات ها را برای خزیدن به کار می گیرند. فایل متنی می تواند شامل ارجاعات خاصی به عوامل کاربر با دستورالعمل های منحصر به فرد برای هر کدام باشد.

Allow: Allow دستوری است که دسترسی روبات ها به صفحات و زیر شاخه های اضافی را فراهم می کند. این ممکن است فقط با ربات های خاصی امکان پذیر باشد.

Disallow: Disallow دستوری است که می توانید آن را در فایل متنی قرار دهید که ربات را از دسترسی به یک URL خاص منع می کند.

تأخیر خزیدن : تأخیر خزیدن مقدار زمانی است که معمولاً در چند ثانیه یک ربات ممکن است قبل از بارگیری و خزیدن محتوا در یک سایت خاص منتظر بماند.

نقشه سایت: نقشه سایت فیلدی در فایل متنی است که نقشه فهرست نقشه های سایت XML یک وب سایت را ارائه می دهد.

مطالب مرتبط: نحوه ایجاد نقشه سایت

چندین بار ممکن است از فایل robots.txt استفاده کنید:

اگر از خزیدن مداوم انتظار ترافیک وب سایت زیادی روی سرور دارید، ایجاد این فایل می تواند به مدیریت هر گونه مشکل عملکرد کمک کند. این فایلها میتوانند به شما کمک کنند تا رباتها را بهجای بارگذاری و استفاده از هر سایت، به اطلاعات و بخشهایی از سایت خود هدایت کنید. میتوانید سایتهایی را که ربات میخزد محدود کنید، مانند سایتهای اضافی یا غیر مهم، بنابراین خزیدن فقط به سایتهای مهم نگاه میکند.

میتوانید از این نوع فایل برای محافظت از فایلهای خاصی مانند تصاویر و فایلهای ویدیویی استفاده کنید. این فایل میتواند از دسترسی روباتهای ناخواسته به فایلها یا صفحات خاص جلوگیری کند، اگرچه سایتهای دیگر همچنان میتوانند به اشیاء پیوند دهند. رسانه شما در موتورهای جستجویی که سایت شما را می خزند ظاهر نمی شود. همچنین میتوانید دسترسی روباتها به فایلهای منبع، مانند فایلهای سبک و اسکریپتها را مسدود کنید. این بدان معناست که سایت می تواند بدون این اشیاء اضافی در موتور جستجو ظاهر شود.

در اینجا چند مرحله وجود دارد که می توانید برای استفاده از فایل robots.txt دنبال کنید:

برای استفاده از یک فایل robots.txt، میتوانید با استفاده از هر ویرایشگر متنی اولیه، آن را ایجاد کنید. هنگام ایجاد آن، می توانید اطلاعات خاصی مانند عوامل کاربر و نقشه سایت را برای هدایت هر ربات اضافه کنید. از آنجایی که هر سایت فقط میتواند یکی از این فایلها را داشته باشد، میتوانید پس از اتمام، نسخه اصلی خود را بهعنوان فایل txt. ذخیره کنید و نام آن را robots.txt بگذارید تا رباتها بتوانند هنگام خزیدن آن را تشخیص دهند.

با استفاده از هر قانون، میتوانید آنها را توسط کاربر دستهبندی کنید و در خطوط جداگانه فهرست کنید. از آنجایی که رباتها اغلب از بالا به پایین میخوانند، میتوانید ابتدا عامل کاربر خاص و سپس سایتهایی را که میتوانند به آنها دسترسی داشته باشند فهرست کنید. برای مثال، قوانین ممکن است به این صورت باشد:

user-agent: searchbotcrawler

allow: https://www.botstxttest.com

disallow: /home.jpg applies to https://www.botstxttest.com/home.jpg

در کل موارد جمله را مرور کنید زیرا روبات ها اغلب به حروف کوچک و بزرگ حساس هستند.

مطالب مرتبط: SEO در مقابل SEM: چه زمانی و چگونه از آنها استفاده کنیم

هنگامی که قوانینی را تعریف کردید، می توانید فایل را در سرور سایت خود آپلود کنید. وقتی در سایت سطح بالا میزبانی می شود، این به درستی عمل می کند. به عنوان مثال، ممکن است به عنوان "https://www.botstxttest.com/robots.txt” ظاهر شود . ممکن است خودتان این کار را انجام دهید یا می توانید با پشتیبانی میزبان وب سایت خود تماس بگیرید تا در صورت نیاز فایل را آپلود کنید.

با داشتن یک فایل زنده در وب سایت خود، آن را آزمایش کنید تا مطمئن شوید که کار می کند. ابتدا می توانید URL را در یک پنجره مرورگر خصوصی باز کنید. چندین گزینه نرم افزار تست وجود دارد که می توانید به صورت آنلاین از آنها استفاده کنید. اینها عملکرد ربات را تقلید می کنند و می توانند به شما نشان دهند که خزیدن بر اساس فایل متنی شما چه کاری انجام می دهد یا برمی گرداند.

مطالب مرتبط: API چیست؟ (به علاوه موارد استفاده و نکاتی برای پیاده سازی)

در اینجا نکاتی وجود دارد که ممکن است هنگام استفاده از این فایل ها به آنها اشاره کنید:

ممکن است در مورد فایل robots.txt محدودیت هایی وجود داشته باشد. برای مثال، برخی از موتورهای جستجو یا رباتها ممکن است برخی از دستورالعملهای ارائه شده توسط شما را نخوانند. این ممکن است به این معنی باشد که این موتورها یا سایر خزنده ها می توانند به اطلاعاتی دسترسی داشته باشند که شما امیدوار بودید از آنها محافظت کنید. به طور مشابه، برخی از خزنده ها ممکن است نحو درون سند شما را به گونه ای متفاوت بخوانند.

مطالب مرتبط: صفحه نتایج موتور جستجو (SERP) چیست؟

از آنجایی که فایل robots.txt فقط جنبه های خاصی از امنیت سایت را کنترل می کند، ممکن است یاد بگیرید که چگونه خزنده ها یا سایت های ربات خاصی را مسدود کنید. می توانید یک تگ “noindex” را به متا تگ های سایت خود اضافه کنید تا مطمئن شوید که در سایت های موتور جستجو ظاهر نمی شود. همچنین می توانید با فعال کردن محافظت از رمز عبور از برخی سایت ها و زیر سایت ها محافظت کنید. از آنجایی که رباتها معمولاً نمیتوانند به این رمزهای عبور دسترسی داشته باشند، احتمالاً میتوانند سایت را بخزند.

وقتی روباتها این فایلهای متنی را میخوانند، فقط به تطابق دقیق پاسخ میدهند. تصحیح هر فایل را برای املا و دقت در نظر بگیرید. همچنین میتوانید هر یک از پیوندهای ارجاعشده در فایل robot.txt خود را بررسی کنید تا مطمئن شوید که پیوندهایی هستند که میخواهید اضافه کنید. بررسی موارد موجود در هر URL برای اطمینان از مطابقت آنها با صفحات وب مرجع می تواند کمک کند.

همچنین بخوانید: htaccess چیست و برای چه مواردی استفاده می شود؟

اگر این مقاله را دوست دارید، لطفا آن را با دوستان خود به اشتراک بگذارید.

![دانلود کتاب: فضای مجازی و سلامت روانی [راهکارهای بهبود روانشناختی در دنیای آنلاین]](https://ivsi.ir/wp-content/uploads/2023/05/virtual-space-and-mental-health-book-300x300.webp)

یک پاسخ

مزایای فایل robots.txt:

۱. بهبود امنیت وب سایت: فایل robots.txt می تواند برای آموزش خزنده های موتورهای جستجو به بخش هایی از وب سایت مورد استفاده قرار گیرد. این می تواند به جلوگیری از نمایه شدن و دسترسی کاربران مخرب داده ها یا صفحات حساس کمک کند.

۲. کنترل بهتر بر روی دید موتورهای جستجو: با استفاده از فایل robots.txt، صاحبان وب سایت می توانند مشخص کنند که کدام بخش از وب سایت آنها باید توسط موتورهای جستجو ایندکس شود و کدام بخش باید حذف شود. این می تواند به بهبود رتبه وب سایت در موتورهای جستجو و دید کلی کمک کند.

۳. زمان بارگذاری سریعتر وب سایت: با حذف صفحات غیر ضروری یا تکراری از خزیدن توسط ربات های موتور جستجو، زمان بارگذاری وب سایت را می توان بهبود بخشید. این می تواند منجر به تجربه کاربری بهتر و عملکرد بالاتر وب سایت شود.

۴. افزایش کارایی بودجه خزیدن: فایل robots.txt می تواند به خزنده های موتورهای جستجو کمک کند تا صفحات مهم را در یک وب سایت اولویت بندی کنند و منجر به استفاده کارآمدتر از بودجه خزیدن وب سایت شود. این می تواند به اطمینان حاصل شود که صفحات مهم بیشتر خزیده شده و ایندکس می شوند.

۵. بهبود عملکرد سئو: با بهینه سازی مناسب فایل robots.txt، صاحبان وب سایت می توانند اطمینان حاصل کنند که خزنده های موتورهای جستجو می توانند به مهم ترین صفحات وب سایت خود دسترسی داشته باشند و ایندکس شوند. این می تواند به بهبود عملکرد سئوی وب سایت و افزایش دیده شدن آن در نتایج موتورهای جستجو کمک کند.